Qué supone esto para el futuro de los LLM y la traducción automática

A la vista de que los LLM serán cada vez más sofisticados, parece que, por ahora, los modelos de TAN personalizados producen resultados más coherentes, ya que es más fácil poseditarlos para obtener una calidad alta, especialmente cuando se trata de contenido en tiempo real procesado en los flujos de trabajo clásicos de sistemas de gestión de proyectos de traducción.

Cabe señalar también que los modelos de TAN muy entrenados, que utilizan contenido y terminología del ámbito concreto, no están sujetos a algunos de los desafíos técnicos y las peculiaridades que se dan con la IA generativa.

La TAN ofrece más predictibilidad, especialmente a lo largo del tiempo, y en idiomas personalizados. También hemos comparado antes los resultados de la TAN genérica y los LLM, y, si bien la calidad es inferior (distancias de posedición superior, etc.), la predictibilidad de los resultados es coherente. En el caso de los LLM, la calidad se reduce, especialmente cuando la lengua original no es el inglés y para idiomas con menos recursos. El contenido producido puede variar bastante con el tiempo.

Por ejemplo, tenemos las alucinaciones de la IA, sobre todo en las lenguas con menos recursos, que pueden afectar al resultado hasta el punto de que la traducción puede no ser útil. Esto se vio en el tratamiento incorrecto de contenidos técnicos, como direcciones URL, frases cortas y terminología concreta de clientes o ámbitos, lo que significa que los LLM aún no producen resultados tan fiables cuando procesan contenidos en grandes cantidades o a escala.

En general, los resultados de Acolad combinados con la revisión humana experta mostraron que, si bien los resultados del LLM obtuvieron una puntuación relativamente alta, el LLM tuvo problemas con contenidos más complejos que incluyen elementos estructurales, como formato y etiquetado a nivel de línea.

Además, con el requisito de gestionar instrucciones relativamente complejas en diferentes idiomas y modelos, la aplicación más amplia de la tecnología de LLM en los flujos de trabajo de la traducción aumentará el coste total de la traducción, pese a que los precios de procesamiento sin revisión están reduciéndose.

Efectivamente, si necesitas traducciones automáticas para grandes cantidades de contenido sin intervención humana ni posedición, seguramente sea mejor elegir una solución de traducción automática probada y de calidad, por ahora.

Tal y como hemos dicho ya, incluso cuando se utiliza un enfoque Human-in-the-loop, en el que un humano se encarga de editar el resultado de la traducción automática, puede ser más eficaz recurrir a la traducción automática, en lugar de la IA generativa, simplemente por el tiempo que se ahorra al no tener que repetir instrucciones para perfeccionar el resultado del LLM. Además, la TAN tiene una distancia de posedición (PED) y una tasa de edición de la traducción (TER) menores, de forma que requieren menos trabajo que empezar con un LLM.

A pesar de los resultados, es evidente que los LLM de IA generativa seguirán teniendo un papel importante en la automatización de la traducción, especialmente a medida que se vayan refinando los modelos. Tiene aplicaciones potenciales interesantes; por ejemplo, en su uso para reescribir estilísticamente el resultado de la TA. Hay pruebas fehacientes de que los LLM podrían tener un papel clave en la evaluación de la calidad, y esto podría reforzar algunas capacidades en traducción, como la posedición autorreflexiva.

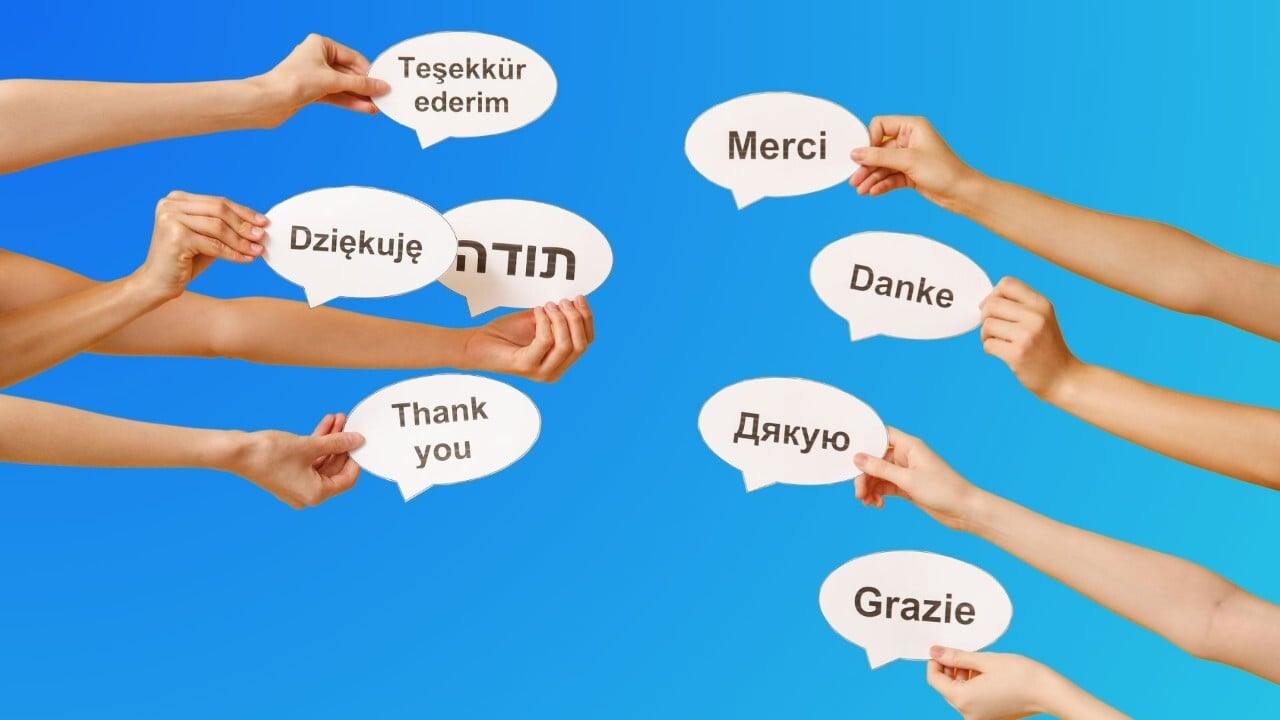

Es evidente que ofrecen posibilidades interesantes a la hora de manejar las ambigüedades, los modismos, las referencias culturales e, incluso, el humor, cuestiones con las que, normalmente, algunos modelos de TA han tenido problemas debido a los conjuntos de datos limitados que se han utilizado para construir sus modelos.